Les LLMs : trop chers et gourmands pour l’Europe ?

En novembre 2024, Aleph Alpha, souvent décrit comme un « concurrent européen de ChatGPT », annonçait renoncer à développer son propre LLM. À la place, ils se concentrent sur un « système d’exploitation » pour aider les entreprises à intégrer l’IA.

Ce choix met en lumière un fait : les LLMs demandent des ressources massives, tant en calcul qu’en capital. Très peu d’acteurs peuvent se permettre de les produire, surtout sans modèle économique viable pour couvrir les coûts d'entrainement et d'utilisation (Open IA n'est pas rentable avec une licence à 200$/mois).

Face à ces contraintes, certains acteurs européens explorent une autre voie : des modèles plus petits et mieux adaptés aux besoins spécifiques.

C’est la stratégie de LightOn, qui travaille sur des modèles autour de 40B de paramètres. Ces modèles offrent des performances suffisantes pour les cas d’usage de leurs clients. Tout en étant plus faciles à déployer, parfois directement chez eux.

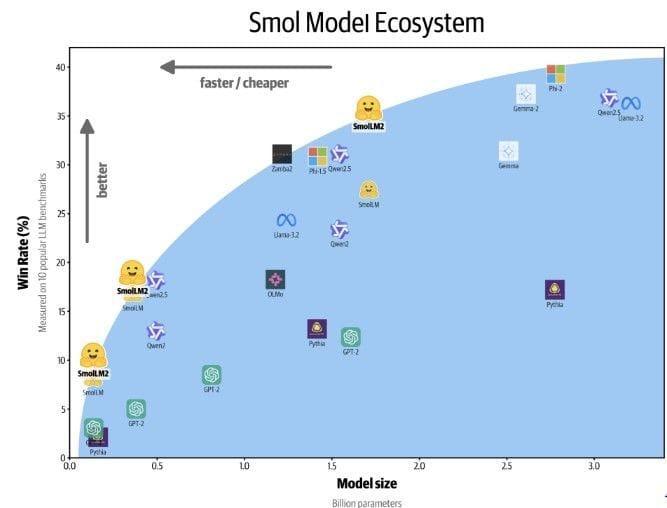

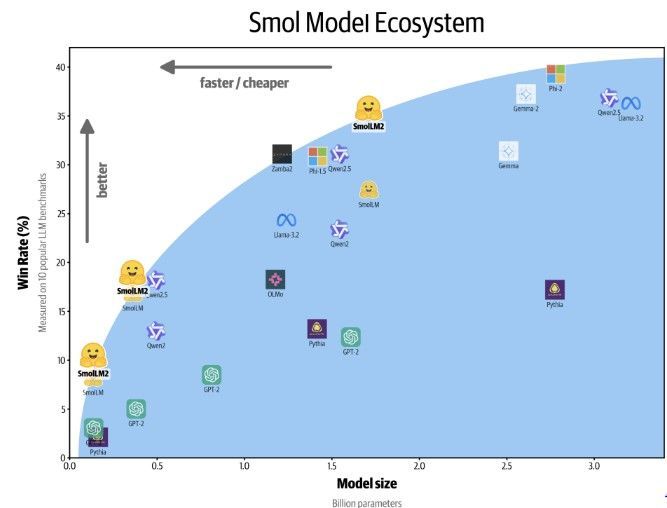

De son côté, Hugging Face développe des modèles encore plus compacts, appelés SLMs. En novembre ils lançaient SmolLM. Suivi il y a quelques jours de SmolLM 2, un modèle 7 x plus petit et 2 x plus rapide développé en collaboration avec Pruna AI.

Ces modèles offrent également des pistes intéressantes pour l'utilisation on-device comme avec PocketPal AI (cf article en commentaire) !

Dans un contexte de tensions sur les ressources et à l’heure où l’Europe cherche à renforcer son autonomie technologique, cette approche de modèles réduits, plus efficaces et spécialisés, semble prometteuse.

Un sujet que je vais creuser dans un épisode à venir pour Les dessous de l'IA !

Source image : Synthetic data and smol models in 2024 - Loubna Ben Allal